运行Spark-Shell命令

在spark/bin目录中,执行“Spark-Shell”命令就可以进入Spark-Shell交互式环境,具体执行命令如下。

$ bin/spark-shell --master <master-url> 上述命令中,“--master”表示指定当前连接的Master节点,<master-url>用于指定Spark的运行模式,<master-url>可取的详细值如表1所示。

表1 master-url参数列表

| 参数名称 | 功能描述 |

|---|---|

| local | 使用一个Worker线程本地化运行Spark |

| local[*] | 本地运行Spark,其工作线程数量与本机CPU逻辑核心数量相同 |

| local[N] | 使用N个Worker线程本地化运行Spark(根据运行机器的CPU核数设定) |

| spark://host:port | 在Standalone模式下,连接到指定的Spark集群,默认端口是7077 |

| yarn-client | 以客户端模式连接Yarn集群,集群的位置可以在HADOOP_CONF_DIR 环境变量中配置 |

| yarn-cluster | 以集群模式连接Yarn集群,集群的位置可以在HADOOP_CONF_DIR 环境变量中配置 |

| mesos://host:port | 连接到指定的Mesos集群。默认接口是5050 |

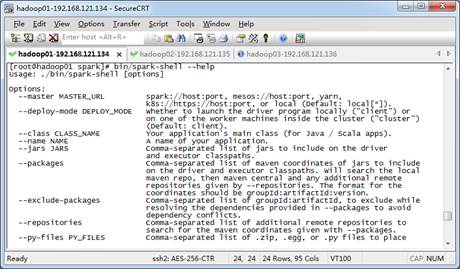

如需查询Spark-Shell的更多使用方式可以执行“--help命令”获取帮助选项列表,如图1所示。

图1 spark-shell帮助命令