DStream编程模型

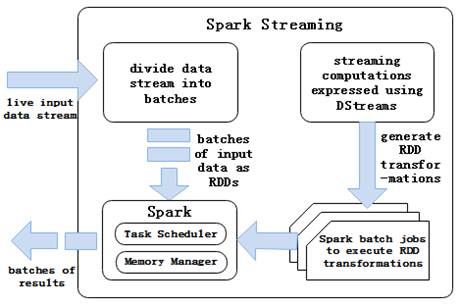

为了便于我们可以更好的使用DStream,接下来,通过一张图对DStream的编程模型进行详细讲解,如图1所示。

图1 DStream编程模型

在图1中,Spark Streaming将实时的数据分解成一系列很小的批处理任务。批处理引擎Spark Core把输入的数据按照一定的时间片(如1s)分成一段一段的数据,每一段数据都会转换成RDD输入到Spark Core中,然后将DStream操作转换为RDD算子的相关操作,即转换操作、窗口操作以及输出操作。RDD算子操作产生的中间结果数据会保存在内存中,也可以将中间的结果数据输出到外部存储系统中进行保存。